Au moment où tout le monde (comment, pas vous? ![]() ) parle de l’Intelligence Artificielle et en particulier les éditeurs de logiciels de CAO, les discussions animées voire enflammées vont bon train, l’intelligence artificielle est-elle intelligente, ou plutôt peut-on la qualifier d’intelligente? Ce qui ramène à l’éternelle question: qu’est-ce que l’intelligence?

) parle de l’Intelligence Artificielle et en particulier les éditeurs de logiciels de CAO, les discussions animées voire enflammées vont bon train, l’intelligence artificielle est-elle intelligente, ou plutôt peut-on la qualifier d’intelligente? Ce qui ramène à l’éternelle question: qu’est-ce que l’intelligence?

[!Success]Ecoutez la conversation !

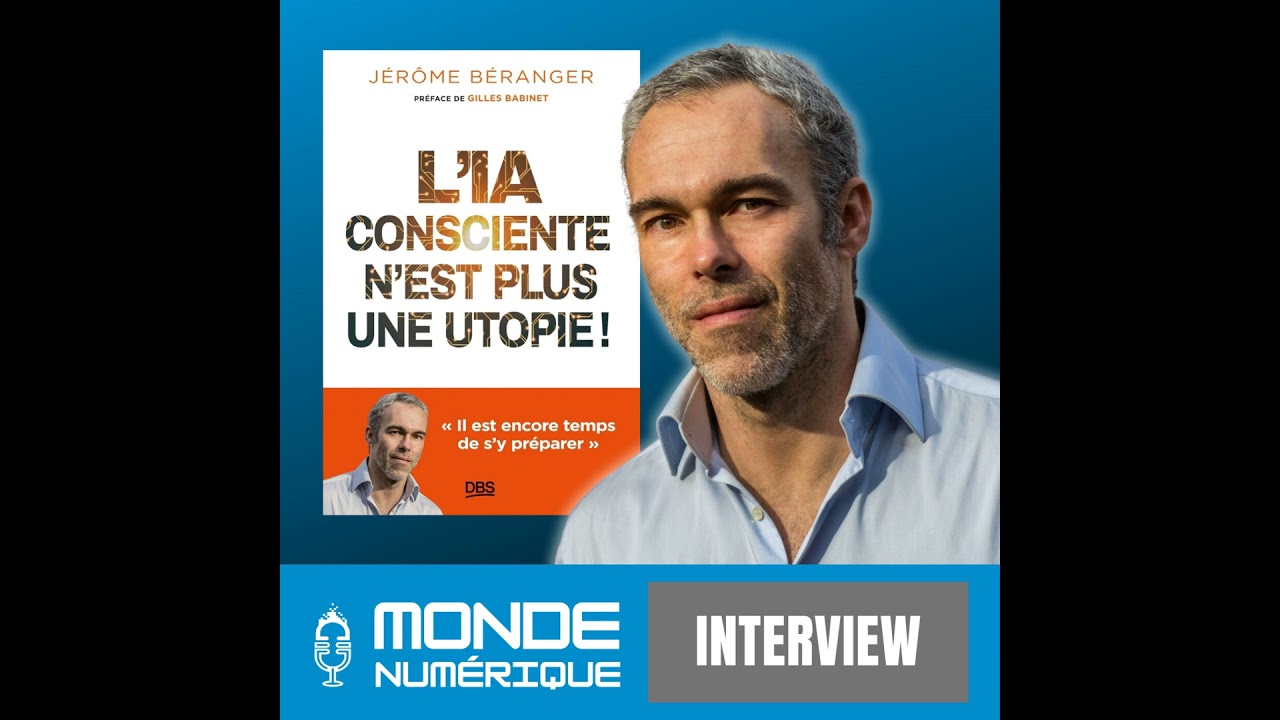

Comme je n’envisage pas de répondre à cette question dans ce post, ni même dans le temps qui me reste à vivre (non non, pas d’inquiétude, la santé, ça va ![]() ), je préfère lancer la discussion et un pavé dans la mare, selon certains chercheurs, et pas n’importe qui, la conscience de la machine est tout simplement… inévitable… (cela a toujours été mon opinion soit dit en passant, je ne suis donc pas choqué par cette étude du 2024-03-24T23:00:00Z ni par les premières théories du genre, je pense à l’Homme Machine de La Méttrie, en… 1748)

), je préfère lancer la discussion et un pavé dans la mare, selon certains chercheurs, et pas n’importe qui, la conscience de la machine est tout simplement… inévitable… (cela a toujours été mon opinion soit dit en passant, je ne suis donc pas choqué par cette étude du 2024-03-24T23:00:00Z ni par les premières théories du genre, je pense à l’Homme Machine de La Méttrie, en… 1748)

Une étude discute d’un modèle théorique de la conscience appelé CtmR, inspiré par les idées de Turing et du Global Workspace (GW) de Baars. Il explore divers aspects de la conscience, y compris la perception consciente, l’accès à l’information, la formation du soi, le contrôle cognitif et la causalité mentale. Le modèle CtmR intègre plusieurs caractéristiques clés des théories de la conscience, notamment l’interaction avec le monde extérieur, la construction de modèles internes et externes, un langage multimodal interne et une mise à jour constante des états par la dynamique prédictive. Le texte soutient que la conscience artificielle est inévitable et que le modèle CtmR fournit une base pour son développement.

Introduction de l’étude par les auteurs:

Nous examinons la conscience sous l’angle de l’informatique théorique, une branche des mathématiques qui étudie le calcul dans des conditions de ressources limitées. Dans cette perspective, nous développons un modèle formel de machine pour la conscience. Ce modèle s’inspire du modèle de calcul simple mais puissant d’Alan Turing et du modèle de théâtre de la conscience de Bernard Baars. Bien qu’extrêmement simple, le modèle s’aligne à un haut niveau sur de nombreuses théories scientifiques majeures de la conscience humaine et animale, soutenant ainsi notre affirmation selon laquelle la conscience de la machine est inévitable.

Et vous qu’en pensez-vous?

- L’intelligence est le propre de l’Homme

- L’intelligence est le propre du monde animal

- Une machine peut être intelligente

- Une machine ne peut pas être intelligente