Une nouvelle recherche d’Autodesk® Research propose une solution automatisée pour répondre aux questions sur les vidéos tutoriels de logiciels complexes. Après avoir analysé 633 questions dans près de 6 000 commentaires, les chercheurs ont constaté que les utilisateurs décrivent souvent des éléments visuels des vidéos. Un système, nommé AQuA, a été conçu pour associer ces questions à des ancres visuelles identifiant des éléments de l’interface utilisateur. Testé sur Fusion 360® avec des participants, ce pipeline génère des réponses précises en combinant ces ancres, la documentation du logiciel, et GPT-4. Les résultats montrent que cette méthode surpasse les approches classiques en qualité et en pertinence des réponses.

Les vidéos tutoriels sont une ressource précieuse pour apprendre à utiliser des logiciels riches en fonctionnalités. Cependant, les apprenants peuvent encore rencontrer des difficultés à comprendre ou à suivre le contenu des tutoriels. Leur seule option dans ce cas est de poser des questions dans la section des commentaires de la vidéo, mais obtenir des réponses peut prendre plusieurs heures, voire plusieurs jours.

Dans cette recherche, nous explorons la possibilité de générer automatiquement des réponses aux questions sur les vidéos tutoriels. Pour mieux comprendre les comportements liés à la formulation de questions, nous avons d’abord analysé 663 questions issues d’environ 6 000 commentaires sur 20 vidéos tutoriels populaires concernant Fusion 360®, un logiciel de CAO 3D. Nous avons identifié quatre grandes catégories de questions et décidé de nous concentrer sur les deux premières, « contenu » et « utilisateur », car elles sont étroitement liées au contenu des tutoriels.

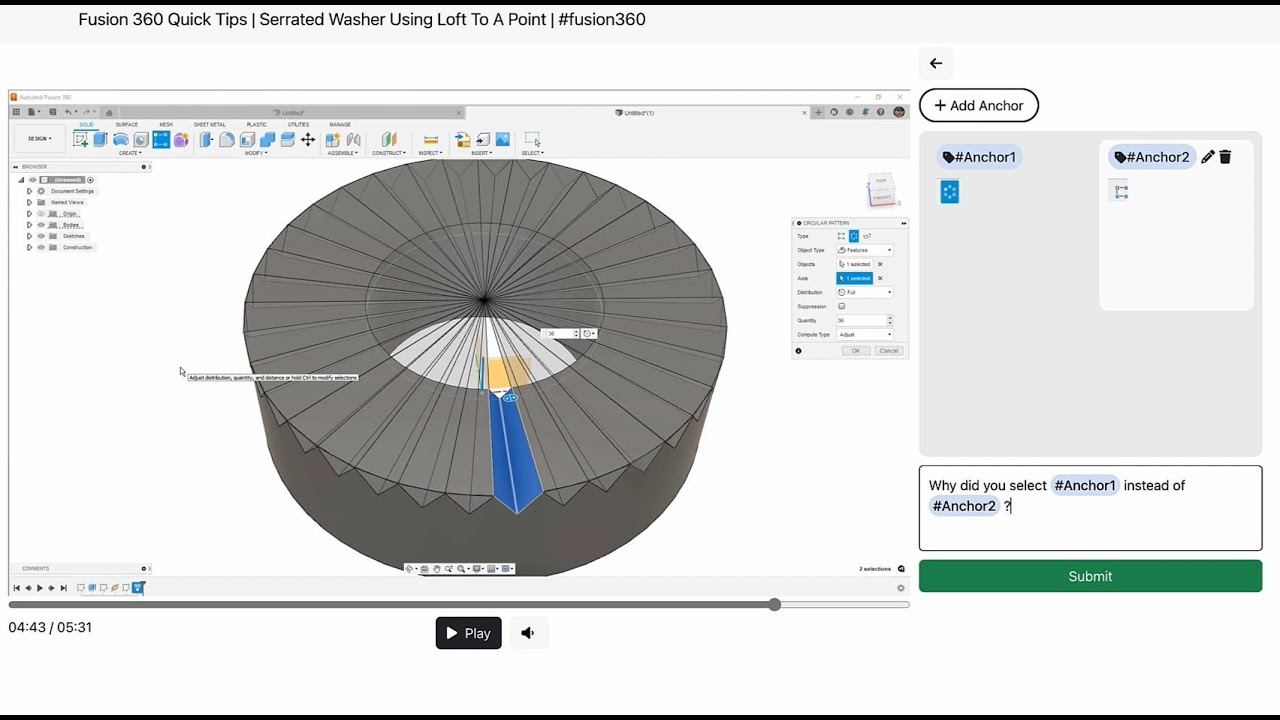

Nous avons constaté que les utilisateurs décrivent fréquemment des éléments visuels des vidéos dans leurs questions. Pour approfondir, nous avons mené une étude sur les types de contenu visuel auxquels les utilisateurs font référence dans leurs questions. Nous avons développé un système permettant aux utilisateurs d’ajouter une référence visuelle à une partie spécifique de la vidéo lorsqu’ils posent une question. Ces références visuelles sont enregistrées dans une galerie, et les utilisateurs peuvent y faire directement allusion dans leurs questions, soit en cliquant sur un élément de la galerie, soit en mentionnant son nom. Il est également possible de faire référence à plusieurs éléments visuels dans une même question.

Nous avons testé ce système avec 24 participants qui ont visionné un tutoriel vidéo (sur Fusion 360®, Photoshop ou Excel) et posé 10 questions accompagnées de références visuelles sur cette vidéo. Nous avons découvert que la majorité des références visuelles concernaient des éléments spécifiques de l’interface utilisateur des logiciels.

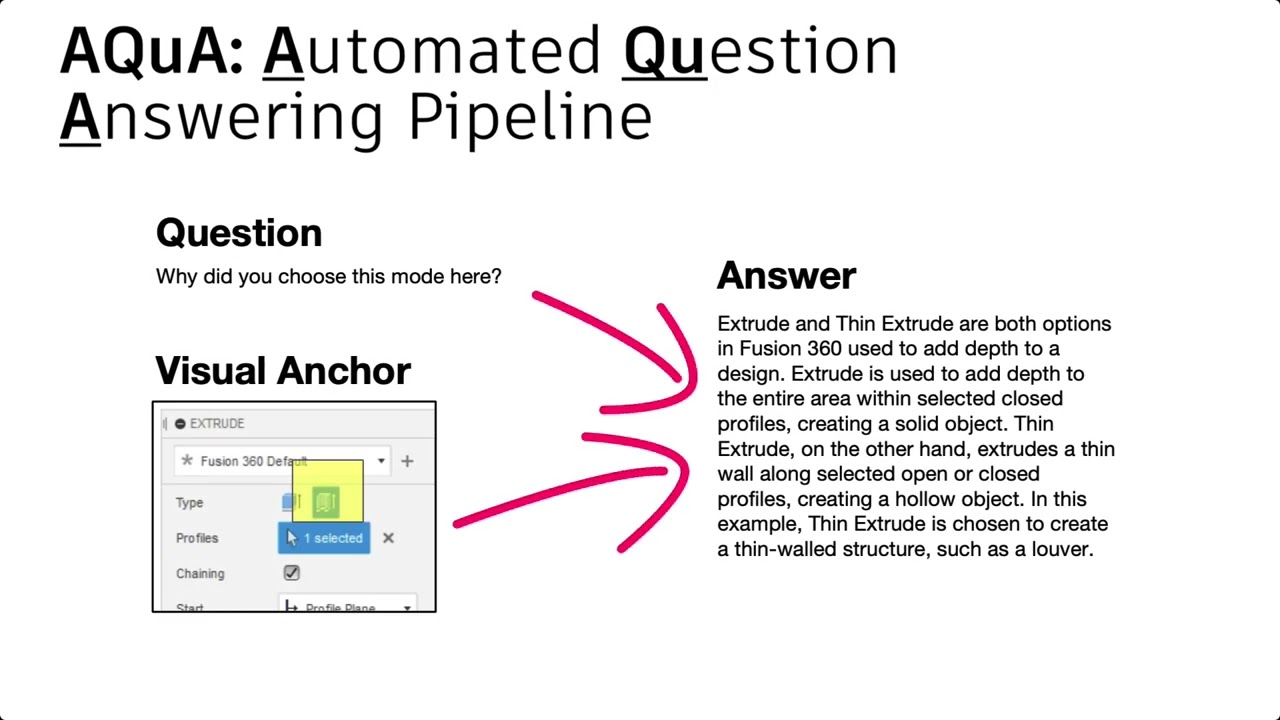

À partir de ces études, nous avons défini des objectifs de conception pour un pipeline de réponse aux questions sur les vidéos tutoriels. Ces objectifs incluent :

- Prendre en compte le contexte de la vidéo au moment où la question est posée.

- Comprendre les références visuelles associées à la question.

- Fournir des informations précises et pertinentes spécifiques au logiciel.

Sur cette base, nous avons développé Aqua, un pipeline de réponses aux questions sur les vidéos tutoriels intégrant des références visuelles. Aqua utilise comme entrées le texte de la question et les références visuelles associées. Un module de reconnaissance visuelle génère une description textuelle des références visuelles en utilisant une base de données des icônes de l’interface utilisateur et de leurs noms. Un module de récupération collecte ensuite des contenus pertinents, comme la documentation produit, les transcriptions d’autres tutoriels vidéo pour le même logiciel, ainsi que le titre et les phrases pertinentes de la transcription de la vidéo concernée. Toutes ces informations sont ensuite transmises à GPT-4 via une invite soigneusement conçue pour produire une réponse utile.

Nous avons évalué notre pipeline avec 16 utilisateurs de Fusion 360®. Pour chaque question, trois réponses générées par des variations du pipeline (texte seul, texte et contexte vidéo, et pipeline complet Aqua) ont été proposées. Les participants ont évalué ces réponses en termes de pertinence et d’utilité, et choisi leur réponse préférée. Les résultats montrent que le pipeline Aqua produit des réponses plus correctes et utiles que les deux autres méthodes de référence et est également le plus apprécié.

Avec notre pipeline conçu pour refléter la manière naturelle dont les utilisateurs posent des questions et intègrent des références visuelles, nous offrons des perspectives sur l’avenir des expériences d’apprentissage interactives et réactives.